你是否曾有过这样的时刻——和朋友倾诉内心,结果对方只轻飘飘地说一句“哦”?那一刻,你是不是觉得对方根本没听懂你在表达什么?这种“被不理解”的挫败感,AI也面临。

随着AI助手、陪伴机器人和虚拟客服的普及,越来越多的用户开始期待——它们能不能“不只是懂语言,还能读懂我们的情绪”?这一设想,正在被一群科学家用VR变为现实。他们的目标不是让AI变“聪明”,而是变“共情”。

2024年以来,MIT、瑞士卢加诺大学等机构相继开展了一系列情绪识别与共情训练实验,让AI“沉浸式地”学习人类情绪。这背后,不只是技术挑战,更牵动着我们对隐私、道德和人机关系的终极思考。

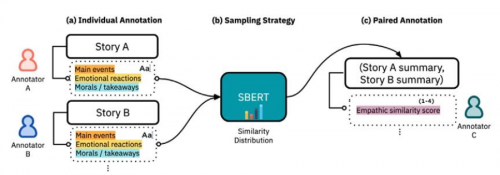

近年来,在MIT媒体实验室,一项名为 EmpathicStories++ 的研究项目悄然展开。这是一套面向人工智能训练的共情多模态数据集,研究人员招募了41名志愿者,在高度沉浸式的VR环境中,真实地讲述自己的人生故事。

这些故事不是剧本——它们包含情绪波动、语速变化、眼神游移、手部动作、甚至微弱的停顿与叹息。整整53小时的VR录音和面部追踪数据,为AI提供了前所未有的“情绪样本”。

为什么要用VR?MIT的研究团队发现,相比摄像头前的讲述,VR环境更能激发讲述者的“真实表达”。他们不再拘谨,而是仿佛对着一位可以倾诉的对象袒露心迹。研究员Jocelyn Shen和她的团队设计了一套多模态同步采集系统,同时记录语音、眼动、面部肌肉细节和空间动作,这样的“数据”比传统文字或语音更能教AI理解“共情”。

这就是所谓的“多模态感知系统”:不仅听你说了什么,更要“看”你怎么说、“察觉”你说话时的情绪状态。这些数据将被送入AI模型中训练,使其在未来对用户的讲述做出更温暖、更自然的回应。

与此同时,在瑞士的卢加诺大学,另一项VR共情研究也在展开。项目名叫 Magic XRoom,它不是为了让AI听懂你说的话,而是让AI“感受”你当下的心理状态。

研究者通过在VR中设置游戏任务(比如让你建造一个小空间站),在过程中收集你的脑电、心跳、皮肤电反应等生理信号。他们重点研究“Flow状态”(即投入但不焦虑的最佳心理体验)在不同人群中的生理表现。最终,AI将学会如何根据这些信号判断你是否紧张、焦虑、无聊,甚至“感同身受”。

Magic XRoom的设计还借鉴了西班牙心理学界的情绪识别方法,比如通过“认知负荷曲线”动态调整VR任务难度,让AI学会在你快要崩溃前先一步“关心”你。这种“主动共情”的尝试,为未来人机互动提供了新可能。

那么,这些研究成果最终将如何落地?目前,多个实验项目已经进入原型测试阶段,尤其集中在医疗与教育场景。

在Magic XRoom的真实测试中,研究人员让参与者佩戴VR头显(如Meta Quest Pro)并同时穿戴生理监测设备,如Empatica手环(监测皮肤电、心率)和Equivital智能背心(监测呼吸与体温)。当受试者在完成一项VR任务时心跳异常加快,系统就会推测其可能处于焦虑状态,并自动降低任务难度或启动语音安抚。

这些数据并不直接“告诉”AI你在想什么,而是通过统计学习和神经网络模型,让AI“自己发现”哪些生理变化与哪些情绪有关。

类似的训练系统也被尝试用于教育领域。MIT团队构想了一种“共情式AI助教”:学生在虚拟教室中提问或答题时,AI通过语音语调、身体动作等判断学生是否理解内容,是否陷入挫败,然后实时给出不同风格的反馈(鼓励、引导、再解释等)。

尽管这些系统仍处于研发阶段,但已经有用户参与原型测试。研究报告显示,这种“情绪感知型AI”在处理儿童表达障碍、老人认知障碍时,表现出更高的互动效果。

不过,研究人员也提醒,训练AI学会“共情”,本质上是让AI接触大量高度隐私化的“情绪原始数据”。如果没有明确的伦理边界和数据保护机制,这些技术也可能反过来成为“情绪操控”的工具。

在所有的论文与项目报告中,一个共同的问题不断被提及——AI理解人类的情绪,并不等于它拥有情绪,更不意味着我们可以无限制地暴露情感。

正如MIT研究团队所强调的:“我们的目标不是制造一个‘会哭会笑的机器’,而是打造一个能在关键时刻‘回应得体’的助手。”这是一场技术与伦理的双重探索——我们既在训练AI的“神经”,也在拷问人类的“底线”。

未来的陪伴型AI、心理辅导机器人或在线教育助理,或许都将具备“共情模块”,但是否要让它“懂太多”?我们需要的不只是技术的飞跃,更是制度与人文意识的同步更新。

AI能否真正“理解”人类?答案或许并不重要。重要的是,在这个由数据与情感交织的时代,我们能否以尊重、善意与谨慎之心,去设计每一个“懂我们”的智能体。科技向善,才是真正的未来。